Przez długi czas zastanawiałem się, czy i kiedy pisać o nowym Pingwinie. Jakiś czas temu w reakcji na dużą niestabilność wyników popełniłem falstart i potrzebne było napisanie sprostowania. Tamten artykuł powstał prawie rok temu. Dzisiaj wiemy, że Pingwin 4 został już faktycznie spuszczony ze smyczy, ale dalej ciężko wyciągnąć praktyczne wnioski. Niemniej pojawiło się parę informacji zasługujących na komentarz, więc zapraszam do lektury i dzielenia się własnymi spostrzeżeniami.

Spis treści

O co chodzi z tym Pingwinem

Google Penguin to aktualizacja algorytmu mająca na celu wychwytywanie stron pozycjonowanych w oparciu o metody linkowania zabronione przez Google (czyli prawie wszystkie…) i korygowanie wyników wyszukiwania poprzez obniżanie pozycji niepokornych webmasterów i marketerów oraz premiowanie tych, które stosują się do wytycznych korporacji z Mountain View. Takie są założenia. W praktyce Google nie może sobie pozwolić na ukaranie wszystkich stron, które posiadają tzw. nienaturalne linki (czyli linki bez parametru nofollow pozyskane z intencji samego zainteresowanego – właściciela strony). Wyniki wyszukiwania to poniekąd gra o sumie zerowej, więc coś w tych topach musi się znaleźć. Podczas wczesnych etapów poprzednich aktualizacji Pingwina obserwowaliśmy zaśmiecanie wyników wyszukiwania zupełnie nieużytecznymi, zaniedbanymi stronami. Później się to uspakajało i do topów wracały często strony, których profil linków był daleki od ideału. Zatem słowa i deklaracje przedstawicieli trzeba ważyć i brać na nie poprawkę. Tyle słowem wstępu.

Jak już wspomniałem, na temat startu nowej aktualizacji Pingwina pojawiało się wiele spekulacji. Tak jest do dzisiaj. Jedno jest pewne – Pingwin ruszył, lecz algorytm ciągle podlega kalibracji. To nie tak, że jednego dnia wyniki wyszukiwania uległy przetasowaniu i tak już zostało. W zależności od strony, branży, zapytania, wyniki bardzo dynamicznie się zmieniają. Rzetelne wnioski będzie można wyciągnąć prawdopodobnie dopiero za jakiś czas.

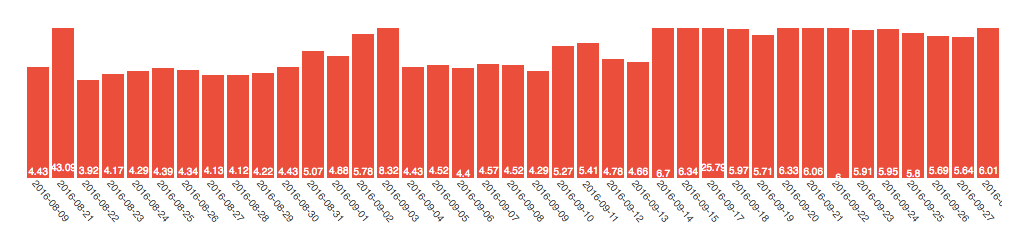

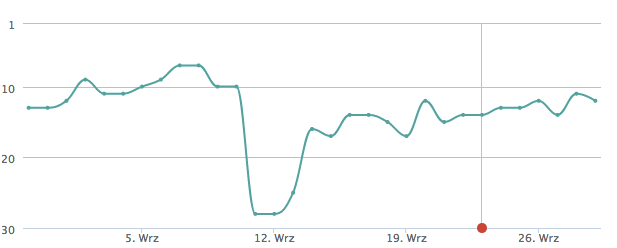

Dla polskich wyników narzędzie serp.watch od wielu dni pokazuje bardzo wysokie odchylenia:

źródło: http://serp.watch/2016/09/29/desktop/poland

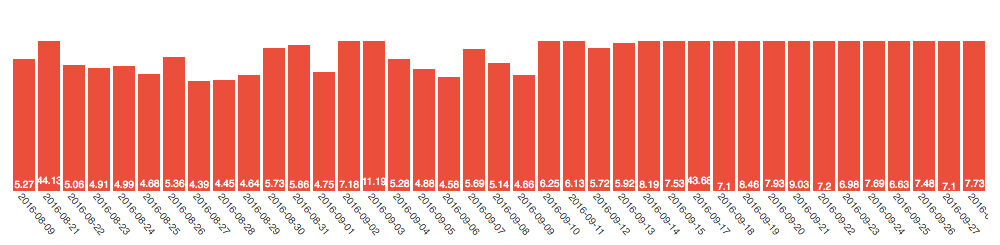

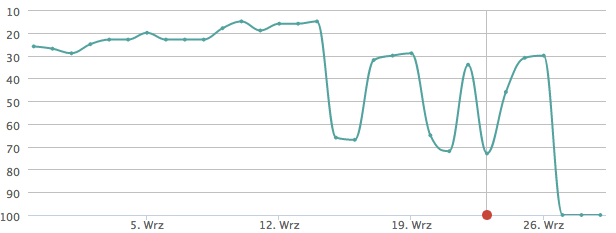

Dla branży e-commerce jest jeszcze ciekawiej:

źródło: http://serp.watch/2016/09/29/desktop/poland/ecommerce

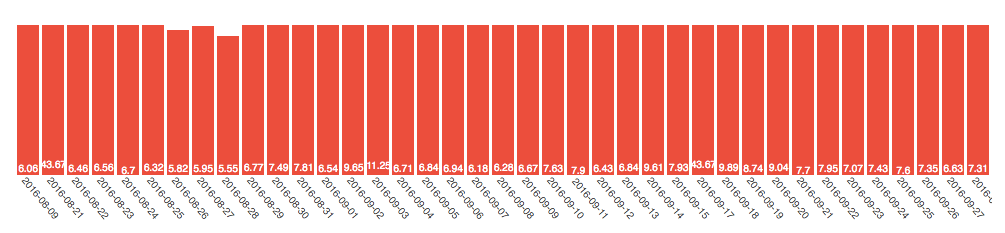

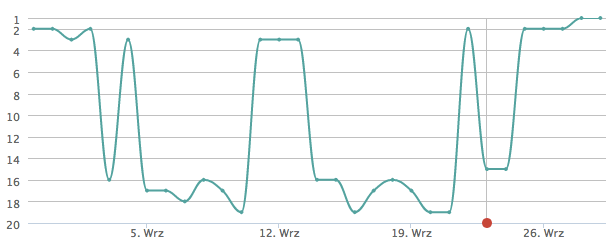

Dotyczy to także wyników wyszukiwania na urządzeniach mobilnych:

źródło: http://serp.watch/2016/09/29/mobile/poland/ecommerce

Dotyczy to oczywiście nie tylko Polski, lecz całego świata. Jak możemy przeczytać w artykule Jennifer Slegg na TheSEMPost:

Potwierdziłam w Google, że ta aktualizacja będzie dotyczyła wszystkich języków i krajów. Zatem nie będzie w tym przypadku sytuacji, w której wdrożenie będzie miało miejsce najpierw w poszczególnych językach. Użytkownicy wyszukiwarki na całym świecie będą mogli zaobserwować zmiany rozpoczynające się właśnie teraz.

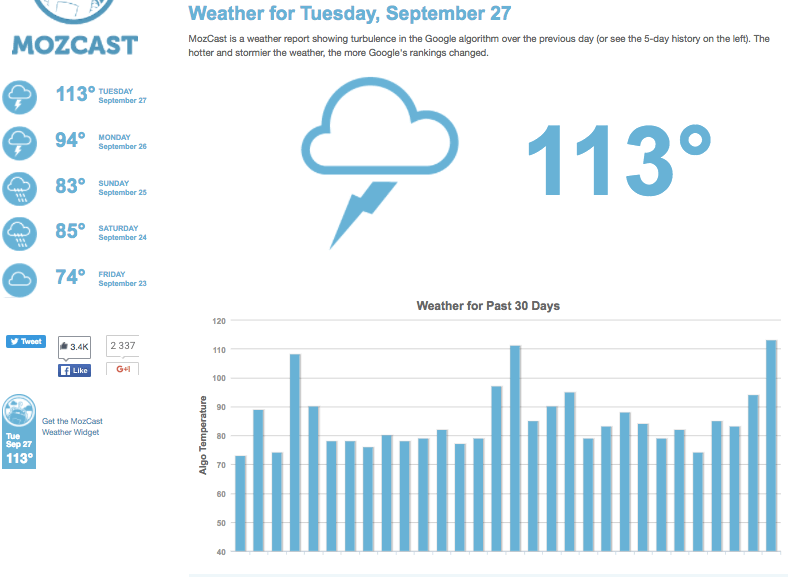

Narzędzie MOZCAST również potwierdza silne zawirowania w wynikach:

źródło: https://mozcast.com/

Deklaracje Google o działaniu Pingwina w czasie rzeczywistym

Co szczególnie ważne, Google zadeklarowało, że nowy Pingwin ma działać w czasie rzeczywistym. Oznacza to, że od momentu, gdy został uruchomiony nie będzie ogłaszanych kolejnych aktualizacji, lecz będzie to element głównego algorytmu, który na bieżąco ustala rankingi. W każdej chwili, każdego dnia Google będzie uwzględniać wskaźniki związane z profilem linków i brać poprawkę na „toksyczne” odnośniki. Tak przynajmniej brzmią deklaracje kalifornijskiego potentata. Z rozmów z innymi praktykami optymalizacji i pozycjonowania można wywnioskować, że w branży SEO dominuje, nazwijmy to, umiarkowany sceptycyzm względem tych wiadomości.

Jakiś czas temu pojawiły się wieści o innym algorytmie Google, który miał działać w czasie rzeczywistym. Chodzi oczywiście o Pandę, która w dużym uproszczeniu skupiała się na jakości stron internetowych i ich zasobów. Panda została włączona co prawda do głównego algorytmu, lecz okazało się, że spekulacje o jej działaniu real-time są przedwczesne, o czym możemy przeczytać między innymi w następujących publikacjach powołujących się na wypowiedzi pracowników Google na Twitterze i podczas Hangoutów:

- TheSEMPost: Google Panda is a Core Ranking Signal, It’s Not Real Time

- Search Engine Roundtable: Google Panda Score Are Not Generated In Real Time

W przypadku Pingwina ma być inaczej i rzeczywiście ma działać w sposób ciągły. Jak będzie w praktyce? Zobaczymy, niemniej taki model działania, chociaż może sprawiać wrażenie najbardziej efektywnego, pozostawia wiele do życzenia i mógłby przynieść efekt odwrotny do zamierzonego.

Implikacje algorytmu Pingwin działającego na bieżąco

Jeśli założylibyśmy, że algorytm działa na bieżąco, to znika obawa, że gdy nasza strona zostanie ukarana filtrem algorytmicznym, to będziemy musieli czekać do kolejnej aktualizacji (ostatnio pechowe strony były „zamrożone” na niskich pozycjach przez praktycznie dwa lata). Jeśli Google chce w ten sposób zniechęcić pozycjonerów do zdobywania linków, to chyba nie tędy droga.

W takiej sytuacji niegłupim rozwiązaniem byłoby działanie po części zgodnie z wytycznymi Google (zadbana strona, rozbudowa struktury i treści pod tzw. długi ogon, budowa wartościowego contentu, budowanie marki i liczenie na pojawienie się naturalnych linków) i jednoczesne wykorzystywanie technik spod znaku czarnego kapelusza, czyli chociażby Systemów Wymiany Linków, zautomatyzowanych i masowych metod zdobywania wielu odnośników ze zoptymalizowanymi słowami kluczowymi w treści etc. Dopóki Google nie zakwalifikuje linków jako toksyczne i będą one wpływać na pozycje, to firma zarobi więcej dzięki lepszemu ruchowi. Jak tylko pojawi się filtr, linki z SWL można odpiąć – znikną z dnia na dzień, a strona osiądzie na pozycjach wynikających z tych bardziej akceptowalnych działań. I tak sukcesywnie można sobie hakować wzrost od filtra do filtra. Czy o to chodzi inżynierom z Google? Nie sądzę.

Pojawia się także większa pokusa, aby stosować działania depozycjonujące wobec konkurencji. Skoro za toksyczne linki dużo częściej będzie można oberwać filtrem algorytmicznym, to czemu nie zainwestować w takie odnośniki prowadzące do strony konkurencji?

Koniec pozycjonowania za efekty?

Nie chcę wieszczyć żadnego końca SEO, końca link buildingu itp. Niemniej firmy, które bazują na modelu rozliczeń za pozycje (wystawiające fakturę w zależności od pozycji osiąganych przez stronę klienta na ustalone słowa kluczowe) mają w chwili obecnej poważny problem. Trwający roll-out algorytmu Pingwin sprawił, że pozycje w niektórych przypadkach potrafią zmieniać się nawet nie codziennie, a parę razy w ciągu dnia. W przypadku niektórych obserwowanych fraz odnotowaliśmy solidne spadki, po których następuje powolny wzrost, a w przypadku innych widzimy totalny rollercoaster świadczący o ciągłej kalibracji czynników w nowym Pingwinie. Kiedyś wyniki były bardziej stabilne i przewidywalne. W tej chwili wygląda to na przykład tak:

Pierwszy przypadek – spadek o ok. 20 pozycji i powolny wzrost:

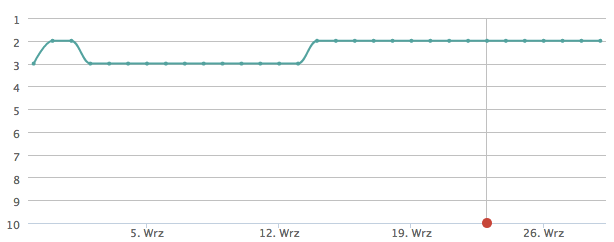

Równocześnie te same podstrony tego samego serwisu na bardzo podobne frazy zachowują się stabilnie:

W innym przypadku widać spore wahania, po których nastąpiło wypadnięcie z TOP100:

W kolejnym przypadku strona z TOP3 wypada w okolice 19. pozycji, kilkukrotnie odnotowuje wahania, aby powrócić na pierwsze miejsce (profil linków nie uległ w tym czasie dynamicznie jakościowemu pogorszeniu, a następnie poprawie):

Powyższe wykresy pochodzą z aplikacji SeoStation.

Pingwin a ignorowanie linków vs. zrzekanie się w disavow tool

Dotychczas zalecaną przez Google (i wielu ekspertów) metodą wychodzenia z filtra było usuwanie toksycznych linków i korzystanie z tzw. disavow tool (więcej o narzędziu do zrzekania się linków przychodzących na oficjalnej stronie Google). Była to kosztowna i czasochłonna forma okazania skruchy (trochę mi się to kojarzyło z czynnym żalem wysyłanym do skarbówki).

Czy to się teraz zmieni? Pojawiają się sugestie, że sztucznie pozyskane linki po prostu przestaną być brane pod uwagę przez Google Penguin 4. Zamiast karać za nie i kazać webmasterom sprzątać sieć ze spamu, Google może po prostu ignorować toksyczne odnośniki i nie brać ich pod uwagę przy ustalaniu rankingu. Abstrahując od technicznych możliwości Google i precyzji takiego mechanizmu (jak Google rozróżni, czy za link w tekście blogera zapłaciliśmy, czy pojawił się tam naturalnie?), jest to poniekąd ciekawy kierunek rozwoju algorytmu. Gdyby to rzeczywiście miało efektywnie działać, to:

- nie opłacałoby się kupować masowo linków pozycjonujących (po co wydawać pieniądze na coś, co nie przynosi żadnych efektów),

- nie opłacałyby się próby depozycjonowania konkurentów (j.w.).

O takim scenariuszu wspomina Gary Illyes (Google) w rozmowie z Barrym Schwartzem (Search Engine Roundtable, Search Engine Land), na który powołuje się Ana Hoffman (Traffic Generation Cafe) w niniejszym poście na Facebooku:

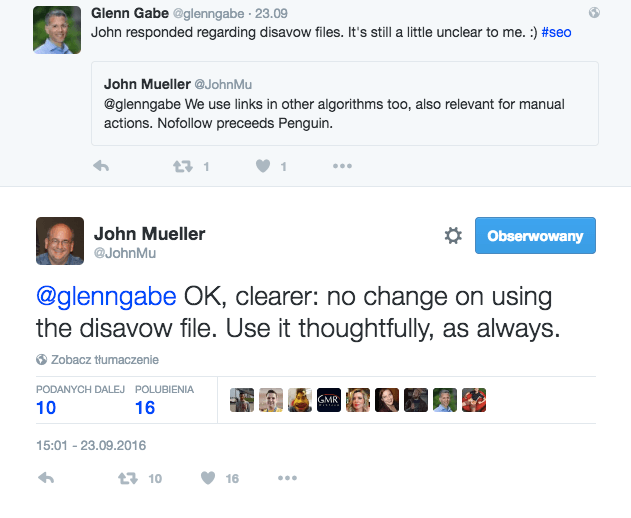

Co ważne, należy pamiętać, że w dalszym ciągu oprócz kary algorytmicznej za spamerskie linki możemy otrzymać karę ręczną – wówczas usuwanie linków i/lub zrzekanie się ich w disavow tool może być konieczne. John Mueller (Google) sugeruje, aby nie zmieniać podejścia do wspomnianego narzędzia:

Jak zwykle Google zostawia nas z wieloma niewiadomymi i deklaracjami, co do których nie ma pewności, czy są przejawem rzetelnego informowania webmasterów o realnym stanie rzeczy, czy próbą kształtowania ich postaw zgodnie z życzeniami kalifornijskich inżynierów.

Jak reagować na Pingwina?

Na koniec jeszcze wspomnę, że oprócz Pingwina Google posiada wachlarz innych narzędzi do karania niepokornych lub nierozważnych marketerów, jak chociażby wspomniane kary ręczne, Quality Update i Panda itd. Warto też wiedzieć, że na przełomie sierpnia i września miała miejsce jeszcze jedna aktualizacja, roboczo zwana Possum (ang. opos), która dotyczyła głównie wyników lokalnych. Ponadto algorytm Google nie jest czymś stałym, co podlega aktualizacji raz na jakiś czas. Mówi się o kilkuset zmianach w skali roku, które nie są ogłaszane i są ciężkie do dostrzeżenia na dużą skalę. Ponadto Google deklaruje, że do głównego algorytmu włączyło nie tak dawno temu tzw. RankBrain, algorytm oparty na uczeniu maszynowym (machine learning; w niektórych publikacjach pojawia się termin sztuczna inteligencja – nie do końca trafiony w tym przypadku).

Jak reagować na obecny stan rzeczy? W przypadku różnych stron, branż i segmentów optymalne taktyki względem nowej odsłony algorytmu Pingwin będą pewnie różne. Niektórzy rzeczywiście będą musieli wykonać kolejny krok w stronę jakościowego marketingu, budowania marki, utrzymywania „czystego” profilu linków, content marketingu, poprawy UX etc., gdy inni, zwłaszcza małe, lokalne biznesy z niewielkimi budżetami obsługiwane przez pozycjonerów skupiających się jedynie na link buildingu, będą efektywnie pozyskiwać ruch na pojedyncze fraz „od kary do kary”.

Pytanie tylko, na ile stabilne będą wyniki i czy samym firmom pozycjonerskim będzie dalej opłacało się działanie w modelu rozliczeń za pozycje – zwłaszcza w przypadku klientów zainteresowanych kilkoma pojedynczymi frazami. Żeby prowadzić biznes konieczna jest jakaś przewidywalność.

Nie będę bawił się w proroka i dawał gotowych recept. Pożyjemy i zobaczymy. Niemniej w przypadku większych biznesów i branży e-commerce zalecałbym skierowanie uwagi na jakościowe metody zorientowane na długotrwałe efekty, wzmacnianie domeny, marki, pozyskiwanie linków z miejsc dających realny ruch, tematycznie powiązanych z ofertą firmy, także ciągłą optymalizację i pracę nad poprawą współczynnika konwersji, szukaniem nisz i rankowaniem na właściwe frazy. Nie chodzi o to, aby być świętszym od papieża i robić wszystko to, co Google każe. Niemniej działania te w długiej perspektywie i tak się zwrócą (chociaż początkowo będą dużo bardziej kosztowne), a mając stabilny fundament można także sobie na więcej pozwolić wspomagając się od czasu do czasu innymi metodami…

zdjęcie w nagłówku na podstawie karenbridge123, Flickr na licencji CC by 2.0

Racja, według mnie usługi pozycjonowania nie opłaca się już robić TOP 1-10, tylko abonament.

Bardzo fajny i merytoryczny wpis. Jednak bardzo ciężko czyta się teksty na waszym blogu na dużych monitorach – czcionka jest bardzo mała.

Dzięki za feedback. Niedługo będziemy poprawiać całą typografię i CSS.

Zadziwiający nie jest fakt wprowadzenia „nowych porządków” bo to dzieje się regularnie (wg.moich obserwacji- co roku – o tej samej porze, by jakto jedni mówią nabić adwordsy tymi co pospadali w serpach) ani PR’woski zabieg czyszczenia internetu dla dobra ogółu, lecz fakt że branża seło odebrała coroczny prezent aby kolejnych naciągać na frazy z niskim szacowanym ruchu w zamian za „abo” bez gwarancji. 😉

Nie tylko w przypadku kary ręcznej warto nadal używać disavow tool, ponieważ w ten sposób pomagamy algorytmowi zidentyfikować nienaturalne linki, czyli przyśpieszamy proces. Polecam artykuł poświęcony temu zagadnieniu: https://widoczni.pl/blog/nowy-pingwin-a-disavow-tool/

Ps. Porównanie disavow do czynnego żalu – bardzo trafne 🙂

Świetny wpis, wartościowa treść i rzeczowe podejście do tematu. Brakuje mi trochę głębszego rozwinięcia podejścia do ewentualnych działań na przyszłość ale rozumiem autora … trudno przewidzieć cokolwiek… Bierzemy słowa za wyrocznie i stosujemy u Nas

Miałam ostatnio bardzo fajny przypadek, na którym jak na dłoni widać działanie algorytmu, a także efekt zrzeknięcia się niechcianych linków: http://martaseoninja.pl/algorytm-czasie-rzeczywistym-filtr-dla-pojedynczej-podstrony-case-study/

zapraszam! 🙂