Narzędzia do analityki i optymalizacji skuteczności sprzedażowej stron stają się coraz popularniejsze. To mnie bardzo cieszy. Jednak uważam, że wraz z ich rozpowszechnieniem powinna następować edukacja marketerów w zakresie badań i wnioskowania statystycznego. Z tym niestety jest bardzo słabo. Dlatego też postanowiłem zwrócić uwagę na kluczowe problemy i zaprosić paru specjalistów, którzy na co dzień zajmują się analityką i pracą z danymi do udzielenia rzeczowego komentarza.

O wypowiedź poprosiłem ludzi z dość różnych bajek. Poniżej swoimi spostrzeżeniami dzielą się Marek Skomorowski (Bain & Co.), Janina Bak (Trinity College Dublin, janinadaily.com), Przemysław Rosa (SalesTube), Piotr Stecko (Chatham Financial), Maciej Lewiński (Akademia Analytics – szkolenia z Google Analytics) oraz Marcin Wsół (www.marcinwsol.pl). Oprócz ich porad, zamieszczę parę słów komentarza z własnej perspektywy, podzielę się swoimi doświadczeniami dotyczącymi testów A/B oraz podkreślę kluczowe kwestie, o których należy bezwzględnie pamiętać decydując się na tę formę badań. Niemniej pozwól, że najpierw wprowadzę Cię w problem, z którym przyjdzie nam się borykać.

Czemu w ogóle się tym zajmuję? Otóż dostajemy w takaoto.pro zapytania ofertowe dotyczące audytów UX i prac mających na celu poprawę współczynnika konwersji, gdzie potencjalni klienci (często na stanowiskach marketerów, managerów) wprost pytają o testy A/B i wykorzystanie narzędzi CRO (ang. conversion rate optimization). W późniejszych rozmowach okazuje się, że mowa o serwisach, które mają zdecydowanie zbyt mały ruch, aby użycie większości tych technik było w ogóle zasadne. Wiem, że równolegle inne agencje i „specjaliści” bez żadnych oporów sprzedają swoje usługi nieświadomym klientom. Jednak w naszych kampaniach, pracach optymalizacyjnych i projektowych bezwzględnie stawiamy na transparentność i uwielbiamy współpracować z klientami świadomymi, którzy chcą rozumieć sens działań, którymi się zajmujemy. Zatem edukujmy się.

Spis treści

Dlaczego wnioskowanie statystyczne jest tak ważne?

Wnioskowanie statystyczne jest niezwykle użyteczną dziedziną wiedzy i każdy marketer powinien przejść chociażby podstawowy kurs z tego zakresu. O ile nie jestem zagorzałym obrońcą formalnego wykształcenia akademickiego, to w tym przypadku studia kierunkowe (niekoniecznie stricte marketingowe – ja np. miałem przedmioty statystyczne na studiach z handlu zagranicznego i międzynarodowych stosunków gospodarczych), mogą dać solidną podstawę do dalszego rozwoju.

Wnioskowanie statystyczne jest kluczowym elementem procesów decyzyjnych w biznesie i marketingu opartym na danych. Jeśli chcemy działać racjonalnie i wyciągać wnioski z dostępnych informacji. Ma to znaczenie zarówno w przypadku danych ilościowych, jak i jakościowych, które też można poddać pewnej kwantyfikacji (chociaż tu też czyhają na nas różne pułapki). Interpretacja korelacji między zjawiskami oraz ocena prawdopodobieństwa, że nasze wnioski są słuszne (a nie są wynikiem przypadku) to kluczowe kompetencje, bez których praca z danymi może przysporzyć nam więcej szkody niż pożytku.

Rozmawiałem ostatnio ze znajomą startuperką, która odbyła warsztaty z korzystania z narzędzi do optymalizacji konwersji. Była zachwycona faktem, że może w tak prosty sposób przetestować różne warianty kreacji na swoim serwisie (strona główna, landing page, formularz kontaktowy etc.) wykorzystując tzw. testy A/B. Niestety podczas warsztatów zabrakło jednej kluczowej informacji – że wyniki takich testów mogą okazać się bezwartościowe, jeśli nie przyjęliśmy odpowiedniej próby, która gwarantuje określoną, pożądaną przez nas istotność statystyczną (więcej na ten temat za chwilę).

Jeśli mamy wyciągać nieuprawnione wnioski, to lepiej w ogóle nie bawmy się w analitykę. Równie dobrze możemy rzucać monetą przy podejmowaniu decyzji. W ten sposób tylko oszukujemy się, że nasze działania mają racjonalne fundamenty, a co więcej, tracimy czas i pieniądze na zbieranie danych i ich obróbkę.

Niestety, w mojej ocenie, dostawcy niektórych narzędzi do testów A/B i optymalizacji konwersji nie kładą nacisku na edukację w tym zakresie, bo dzięki temu mogą dotrzeć do większej liczby klientów – właścicieli serwisów z bardzo małym ruchem. Trochę jednak strzelają sobie w kolano, bo na dłuższą metę źle wykorzystywane narzędzia nie przysłużą się rynkowi, a użytkownicy przestaną z nich korzystać na dużą skalę.

Istotność statystyczna – na chłopski rozum

Gdy rozmawiam z klientami, marketerami, partnerami na temat różnego rodzaju testów i analiz i gdy pojawia się problem ze zrozumieniem istotności statystycznej, podaję prosty przykład.

Załóżmy, że mamy coś do przetestowania – obojętne czy to będzie formularz kontaktowy, banner reklamowy czy landing page. Prosimy 3 osoby, aby powiedziały, która opcja (jedna z dwóch) podoba im się bardziej. I co się okazuje? Dwie osoby wybrały wariant A, a jedna wariant B. Czy to znaczy, że możemy stwierdzić, że wariant A będzie lepszym rozwiązaniem? Chyba nie 🙂

No to prosimy kolejną osobę i okazuje się, że wybiera również wariant A – mamy już 3:1. Niemniej wciąż to chyba za mało, aby stwierdzić jednoznacznie, że wariant A jest lepszy. Gdy poprosimy więcej osób o opinię, może się okazać, że preferencje zwolenników wariantu A nie były reprezentacyjne dla całej grupy docelowej i każda kolejna osoba wybierze wariant B. Po przepytaniu 10 osób mamy wynik 3:7 na korzyść wariantu B. I znowu pojawia się pytanie – czy to wystarczy, aby stwierdzić, że to jednak wariant B będzie tym skuteczniejszym? Nie!

Teoretycznie moglibyśmy tak w nieskończoność, bo zawsze istnieje jakieś ryzyko, że przy zwiększeniu liczby badanych (respondentów, uczestników testu etc.) te proporcje się odwrócą. Jednak wraz ze wzrostem liczby badanych (tzw. próby) prawdopodobieństwo popełnienia błędu maleje. Przy grupie 3 osób jest bardzo wysokie. Przy grupie 100 mniejsze i tak dalej.

Istotność statystyczna to miara prawdopodobieństwa, że statystyka odzwierciedla rzeczywistość i można na jej podstawie wyciągać racjonalne wnioski. To prawdopodobieństwo nigdy nie wyniesie 100%, ale jeśli osiągniemy poziom 95% lub najlepiej 99%, to już mamy solidne podstawy do wyciągania wniosków.

Dla każdego badania wielkość próby będzie inna, bo zależy od kilku czynników, jednak nie chodzi o to, aby każdy umiał ją policzyć w pamięci (o tym później – także w wypowiedzi Marcina), lecz o to, aby rozumieć samą koncepcję, zasadą i za każdym razem zadać sobie pytanie, czy wnioski które wyciągamy są statystycznie istotne.

Oczywiście prowadząc testy musimy pójść dalej i przygotować całą metodologię badania (pytanie ludzi o opinię nie jest zazwyczaj najlepszym pomysłem i nie daje miarodajnych rezultatów, gdyż opiera się na danych deklaratywnych), niemniej chodzi o to, aby zrozumieć ideę dotyczącą wielkości próby, którą musimy sobie zapewnić, aby wyniki były istotne statystycznie.

Lekcje od ekspertów

Jak już wspomniałem, zaprosiłem do podzielenia się swoimi uwagami i spostrzeżeniami kilku znajomych specjalistów, którzy z wnioskowaniem statystycznym mają kontakt na co dzień – w różnych dziedzinach, od świata akademickiego, przez marketing w mediach społecznościowych, reklamę w wyszukiwarkach, po pracę na produkcie cyfrowym (np. aplikacji) i świat finansów:

Marek Skomorowski:

Biznes i statystyka idą w parze. Niestety, rzadziej do tej pary dołącza umiejętność interpretacji danych statystycznych przez managerów czy właścicieli firm. Nie wystarczy skonstruować ankiety, zadać pytania o to, co klienci chcieliby zmienić w produkcie i na tej podstawie dokonać poprawek. Zbyt często okazuje się, ze wnioski są blednę, bo nie wzięło się pod uwagę tego, kogo pytamy, w jaki sposób pytamy i jakie informacje pozyskujemy. Z mojego doświadczenia najwięcej na sumieniu organizacje maja w związku z dwoma ostatnimi kwestiami, czyli bardziej precyzyjnie – z tworzeniem narzędzi badawczych i interpretacją danych. Trudno uzyskać sensowne wnioski, jeśli na przykład wprost zapytamy o to, czego klienci oczekują po naszym produkcie. Zazwyczaj nie wiedzą oni, co byłoby dla nich najpotrzebniejsze albo co zachęciłoby do kupna produktu. Druga sprawa to interpretacja zebranych danych. Zbyt często ogranicza się do porównania średnich, a pomija choćby odchylenie standardowe czy błąd próby. Czasem wynika to z niewiedzy a częściej z potrzeby podjęcia decyzji na podstawie „twardych” danych. Tyle, że prowadzi to do błędów i w efekcie można np. udoskonalić produkt o cechę A, która bardzo silnie podobała się niewielkiej grupie klientów, a większość drażni.

Marek Skomorowski, konsultant w Bain & Co., w przeszłości project manager w mBanku i Syniverse Technologies w Chicago, gdzie zajmował się m.in. rozwojem aplikacji mobilnej, strategią marketingową dla różnych linii produktowych oraz analizą potrzeb klientów w oparciu o badania oraz dane wewnętrzne. Absolwent Uniwersytetu Łódzkiego oraz programu MBA na Kellogg School of Management

Marek Skomorowski, konsultant w Bain & Co., w przeszłości project manager w mBanku i Syniverse Technologies w Chicago, gdzie zajmował się m.in. rozwojem aplikacji mobilnej, strategią marketingową dla różnych linii produktowych oraz analizą potrzeb klientów w oparciu o badania oraz dane wewnętrzne. Absolwent Uniwersytetu Łódzkiego oraz programu MBA na Kellogg School of Management

Janina Bak:

Statystyki nie kłamią, ale ludzie często kłamią na temat statystyk. Podawanie wyników testów A/B, chociażby i najbardziej imponujących („zmiana koloru przycisku zwiększyła konwersję o 456% [ZOBACZ MEMY]”) przy jednoczesnym ignorowaniu innych danych, takich jak wielkość i dobór próby, czy istotność statystyczna, nie różni się niczym od reklamy, która głosi, że 90% konsumentów potwierdza skuteczność szamponu, a potem małym druczkiem dodaje, że badanie przeprowadzono na grupie 10 osób, z czego wszyscy byli kuzynami prezesa. O ile znaczenie losowego doboru odpowiednio dużej próby jest stosunkowo proste do zrozumienia, o tyle istotność statystyczna jest dla wielu wynalazkiem niezrozumiałym albo – co gorsza – zbędnym.

Tymczasem istotność statystyczna jest kluczowa dla prawidłowej interpretacji testu, albowiem określa, na ile możemy ufać własnym wynikom. Testy A/B przeprowadzamy jedynie na frakcji naszych klientów, dajmy na to na grupie 1000 osób z 10 000. Istotność statystyczna podpowiada nam, na ile otrzymane wyniki możemy wygeneralizować na całą populację, czyli wszystkich naszych klientów. To znaczy – jeśli nasz test wykazał, że zielony przycisk „kup teraz” konwertuje lepiej niż czerwony, to istotność statystyczna określa nam prawdopodobieństwo, z jakim wdrożenie zielonego przycisku na stronie rzeczywiście przełoży się na wzrost konwersji, to jest – czy nie uzyskaliśmy takiego wyniku jedynie przez przypadek.

W dużym uproszczeniu można powiedzieć, że istotny statystycznie test A/B daje nam odpowiedź na kluczowe dla nas pytanie, to jest: „czy to rozwiązanie naprawdę działa?”.

Janina Bak. Przez cztery ostatnie lata uczyła metodologii badań i statystyki na Trinity College Dublin w Irlandii. Od zawsze jest psychofanką badań ankietowych, już niedługo także doktorem nauk społecznych. Umie liczyć, opowiadać i opowiadać o liczeniu, co w wolnej chwili robi na blogu janinadaily.com.

Janina Bak. Przez cztery ostatnie lata uczyła metodologii badań i statystyki na Trinity College Dublin w Irlandii. Od zawsze jest psychofanką badań ankietowych, już niedługo także doktorem nauk społecznych. Umie liczyć, opowiadać i opowiadać o liczeniu, co w wolnej chwili robi na blogu janinadaily.com.

Przemysław Rosa:

Jaki jest największy problem z testami A/B na Facebooku? Problem jest taki, że wiele osób twierdzi, że tego typu testy realizowały

nawet gdy w panelu reklamowym nie było takiej możliwości (pojawiła się ona w zależności od konta parę miesięcy temu czyli na przełomie 2016 i 2017).Wcześniej wiele osób przez testy A/B rozumiało uruchomienie w ramach jednego adsetu skierowanego do wybranej target grupy dwóch kreacji reklamowych a następnie porównywanie innych. W czym tkwi problem? Otóż Facebook dość szybko (wg obiegowych opinii już po kilkuset odsłonach reklamy) wybiera kreację, którą mocniej wspiera przekazując na nią większość budżetu. Porównywanie wyników kreacji z których jedna była wspierana przez X budżetu a druga przez 2000% X budżetu

mija się z celem bo w takich sytuacjach stykamy się z „dziwnymi danymi” – później czasem trudno początkującemu w reklamie na FB klientowi wyjaśnić dlaczego większy budżet został przeznaczony na reklamę z niższym wskaźnikiem CTR.Zwykle kiedy czytam wyniki testów A/B mam problem z tym, że niektórzy autorzy podają różnice oparte na istotności statystycznej. Z punktu widzenia purysty statystycznego, aby podawać takie istotności musielibyśmy operować na populacji na temat której mamy zebrane dane odnośnie prawdopodobieństwa trafienia każdej pojedynczej jednostki do naszej próby badawczej. Zwykle w testach A/B w Internecie nie działamy w takich warunkach stąd z przymrużeniem oka należy patrzeć na podawanie istotności statystycznej wyników.

O testach A/B często się mówi w konteście badań UX – wielkość prób przy takich badaniach (jest to po 20-30 osób, które są podłączone do eye trackingu) sprawia, że takie badania mają charakter jakościowy, a nie ilościowy. Stąd w opisach wyników takich badań należy się powstrzymać od wniosków typu – 60% respondentów zaczyna przeglądać stronę internetową od lewej kolumny.

Przemysław Rosa, Paid Social Manager w SalesTube

Piotr Stecko:

Wyciąganie wniosków na podstawie zebranej statystyki jest niezwykle powszechną czynnością, zwłaszcza pomocną, przy podejmowaniu decyzji finansowych w firmach. Klasycznymi przypadkami takich problemów jest próba oszacowania przyszłych dochodów (kosztów) lub wartości zagrożonej ryzykiem. W tym kontekście warto wspomnieć o zależności pomiędzy ilością zebranych danych, ich istotnością a końcową decyzją. Czy, na przykład, prognozowanie dochodów na przyszły rok na podstawie kilku wybranych okresów jest sensowne tylko dlatego, że ich istotność jest odpowiednio niska? Z drugiej strony, uwzględnienie historii strat za zbyt szeroki okres pomoże uzyskać „reprezentatywne” wyniki o wysokim poziomie wiarygodności kosztem uśrednienia trendów. Dlatego też, przy podejmowaniu decyzji, należy zwrócić szczególną uwagę na jakość oraz ilość zebranych danych, które potem mogą bezpośrednio przełożyć się na stan firmowego konta.

Piotr Stecko: FRM oraz Tech Lead w firmie Chatham Financial. Na co dzień zajmuje się budowaniem modeli finansowych do wyceny instrumentów pochodnych oraz zarządzania ryzykiem. Sporą część czasu

Piotr Stecko: FRM oraz Tech Lead w firmie Chatham Financial. Na co dzień zajmuje się budowaniem modeli finansowych do wyceny instrumentów pochodnych oraz zarządzania ryzykiem. Sporą część czasu

spedza również na analizie danych i optymalizacji wydajności aplikacji.

Maciej Lewiński

Eksperta podobno poznaje się po ilości porażek jakie poniósł w swojej dziedzinie. Czas w takim razie na małe wyznanie. Przeprowadziłem ponad setkę testów korzystając przy tym z najnowocześniejszych technologii i oprogramowania. Większość z moich testów okazała się jednak nierozstrzygnięta, bo testowałem rzeczy które nie miały wpływu na konwersje. Były zbyt mało znaczące. Dlatego podchodząc do testów warto przede wszystkim zanurkować w swoich danych i umiejętnie zdiagnozować problem z jakim się mamy zmierzyć – wąskie gardła. Następnie na tej podstawie postawić hipotezy mające udrożnić nasze wąskie gardło i testem znaleźć odpowiedź na pytanie, która hipoteza była najtrafniejsza. Niczego nie zakładać. Cierpliwie czekać na respond ze strony użytkowników.

Prowadząc szkolenia z Google Analytics spotykam się z wieloma marketerami, którzy w pierwszej kolejności testują “internetowe dogmaty” takie jak kolory przycisków czy też napisy na nich. Jest to absolutnie jakiś pomysł na test, ale decyzje konwersyjne podejmujemy między innymi przez treść, a nie samą formę. Oczywiście sposób przedstawienia treści jest ważny, ale są rzeczy ważne i ważniejsze 😉 Więc jeśli przymierzasz się do uruchomienia pierwszego testu przetestuj swoje copy na stronie. Zatrudnij 2-3 copywriterów, którzy swoimi słowami i językiem korzyści opiszą to co masz do zaoferowania. Wyniki testu Cię zaskoczą!

Maciek Lewiński zajmuję się rozwiązywaniem problemów małych, średnich i dużych firm z Google AdWords i Google Analytics. Powołał go do tego… sam Google. Jest Certyfikowanym Trenerem, któremu gigant powierzył edukowanie agencji SEM w ramach projektu Akademia Google Partners oraz konsultowanie najtrudniejszych przypadków. Działa także w ramach Centrum Pomocy Google, a za merytoryczne wsparcie oficjalnego forum Google otrzymał tytuł Najlepszego Współtwórcy Forum Google.

Maciek Lewiński zajmuję się rozwiązywaniem problemów małych, średnich i dużych firm z Google AdWords i Google Analytics. Powołał go do tego… sam Google. Jest Certyfikowanym Trenerem, któremu gigant powierzył edukowanie agencji SEM w ramach projektu Akademia Google Partners oraz konsultowanie najtrudniejszych przypadków. Działa także w ramach Centrum Pomocy Google, a za merytoryczne wsparcie oficjalnego forum Google otrzymał tytuł Najlepszego Współtwórcy Forum Google.

Marcin Wsół

Przyjęło się, że testy A/B dotyczą głównie stron docelowych, by sprawdzić czy zmiana poszczególnych elementów tych stron wpłynie na poprawę współczynnika konwersji. A przecież w ten sposób można testować dosłownie wszystko 🙂 Pozostaje kwestia, na ile będzie to miarodajne. W systemie AdWords najczęściej testujemy różne wersje reklam (zarówno tekstowych jak i graficznych), ale mało kto zastanawia się, czy ze statystycznego punktu widzenia podejmuje prawidłowe decyzje co do skuteczności reklam. Jeśli dana wersja reklamy ma większy współczynnik konwersji, to jako pewnik przyjmujemy, że jest ona skuteczniejsza. Wynika to często z niewiedzy lub braku umiejętności w obszarze statystyki, ale z drugiej strony sam system AdWords nie oferuje szybkich rozwiązań do oceny skuteczności reklam. Osobiście brakuje mi dodatkowej funkcji, która oceniałaby skuteczność reklam na podstawie liczebności próby bez konieczności wcześniejszego uruchamiania eksperymentów.

Pozostaje również kwestia czasu – gdyby dla każdej reklamy w grupie reklam obliczać „na piechotę” istotność statystyczną według wzorów, nie wystarczyłoby dnia na optymalizację pozostałych kampanii 🙂 Aby szybko sprawdzić, czy uzyskane przez nas wyniki są istotne statystycznie polecam skorzystać z tego narzędzia – https://neilpatel.com/ab-testing-calculator/ – wystarczy wpisać liczebność próby oraz liczbę konwersji, a system sam określi, czy testy A/B są istotne statystycznie.

Z kolei w systemie AdWords możemy skorzystać z eksperymentów na podstawie wcześniej przygotowanej wersji roboczej kampanii. Więcej informacji znajdziesz tutaj – https://support.google.com/google-ads/answer/6318732?hl=pl.

Niezależny certyfikowany specjalista Google AdWords i Google Analytics z ponad sześcioletnim doświadczeniem; posiadacz wszystkich branżowych certyfikatów Google oraz certyfikowany partner Google Premium; współautor drugiego wydania „Biblii e-biznesu” i autor licznych tekstów w branżowych magazynach.

Niezależny certyfikowany specjalista Google AdWords i Google Analytics z ponad sześcioletnim doświadczeniem; posiadacz wszystkich branżowych certyfikatów Google oraz certyfikowany partner Google Premium; współautor drugiego wydania „Biblii e-biznesu” i autor licznych tekstów w branżowych magazynach.

Testowe ABC

Masz już obraz sytuacji, prawda? Rozumiesz, jak ważna jest rzetelna praca z danymi. Na koniec podrzucę Ci kilka praktycznych wniosków, dzięki którym łatwiej Ci będzie prowadzić działania marketingowe i podejmować decyzje biznesowe w oparciu o testy porównawcze.

Dobór wielkości próby do testów

Jest kilka istotnych kwestii, o których należy koniecznie pamiętać przy prowadzeniu testów typu A/B. Pierwsza to dobór odpowiedniej próby. Będzie ona inna w zależności od:

- wyjściowego poziomu współczynnika konwersji, który chcemy poprawić (wartość bazowa),

- oczekiwanego poziomu zmian (jak dużą zmianę chcemy zaobserwować),

- poziomu istotności statystycznej (jakie ma być prawdopodobieństwo, że nasze wnioski są prawdziwe – sugeruję przyjmować 99% chociaż w niektórych badaniach społecznych i ekonomicznych przyjmuje się poziom 95%, aby ułatwić badania).

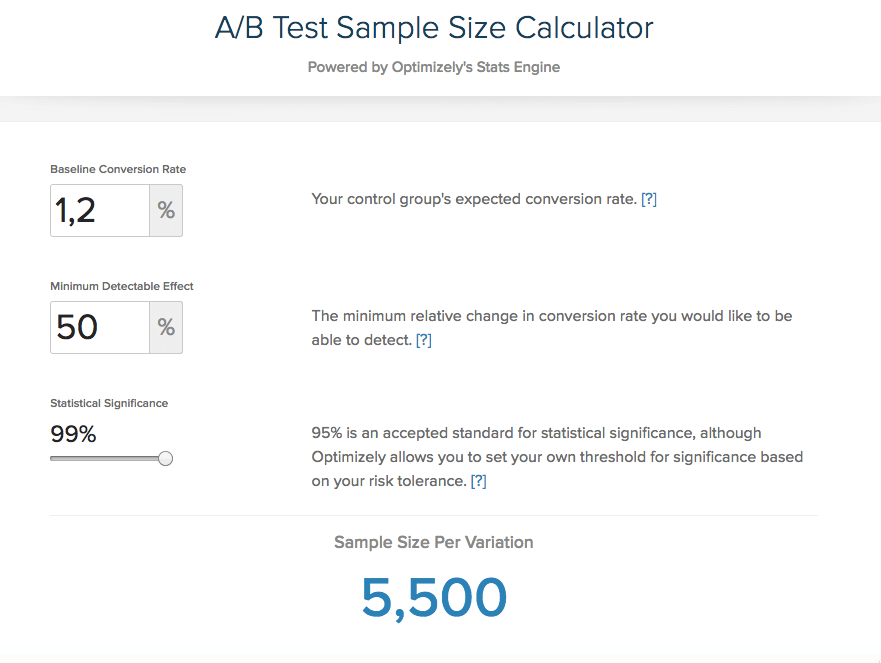

Aby wyliczyć konkretną liczebność próby (czyli np. użytkowników, których wpuścimy na stronę, aby zaobserwować, jak się zachowują w przypadku kontaktu z formularzem w wersji bazowej i formularzem w wersji testowej), można skorzystać z ogólnodostępnego kalkulatora – np. Sample Size Calculator od Optimizely.

źródło: https://www.optimizely.com/sample-size-calculator/

Jak widać na załączonym obrazku, przeprowadzenie testu, którego celem ma być poprawa współczynnika konwersji co najmniej o jedną piątą, gdy bazowy współczynnik wynosi 1,2% (przy istotności statystycznej na poziomie 99%), wymaga ruchu rzędu 38000 na każdy z wariantów. Czyli w praktyce musimy mieć ruch na poziomie 76000 użytkowników, aby móc wyciągnąć sensowne wnioski. Przy mniejszym ruchu po prostu rośnie ryzyko, że decyzje podejmowane w oparciu o wyniki testu będą błędne (bo będą opierać się na nieprawdziwych założeniach).

Oczywiście możemy sobie wyobrazić sytuację, w której chcemy zaobserwować dużo wyraźniejszą zmianę współczynnika konwersji. Na przykład o połowę! Wówczas wymagana próbka będzie mniejsza. To częste podejście w działaniach optymalizacyjnych, ponieważ cały proces jest kosztowny (projekty, wdrożenia), więc opłaca się go realizować jedynie w przypadku możliwości osiągnięcia pokaźnych korzyści biznesowych.

Źródło: https://www.optimizely.com/resources/sample-size-calculator/

Jednak nawet w tym przypadku widać, że musimy wygenerować ruch na poziomie 11000 użytkowników, aby móc wyciągać wnioski. W przypadku początkujących startupów lub małych sklepów działających w niszowych branżach to bardzo duże ograniczenie.

Czas realizacji testu

Ktoś może zapytać – OK, 11000 użytkowników, ale w jakim czasie? Może po prostu wystarczy poczekać 2-3 miesiące? – i będzie to pytanie jak najbardziej sensowne. O liczbie użytkowników musimy mówić w konkretnych ramach czasowych. Jakie są optymalne? Szczerze mówiąc, im szybciej, tym lepiej. Pamiętajmy, że nie działamy w warunkach laboratoryjnych i na zachowania ludzi (użytkowników, klientów) wpływa szereg czynników, które pozostają poza naszą kontrolą. Powinniśmy zadbać o to, aby pozyskiwany ruch był w miarę możliwości jednolity. Na to będą miały wpływ między innymi źródła pozyskania ruchu.

Źródła ruchu w testach A/B i reprezentacyjność próby

Należy pamiętać, że próba użytkowników, na podstawie zachowań i wyborów której będziesz podejmować decyzje, musi być reprezentatywna dla populacji Twoich klientów. Jeśli na co dzień nastawiasz się na ruch organiczny z wyszukiwarki, a do testów wykorzystasz ruch z reklamy płatnej na Facebooku lub wynikający z jakiejś innej formy promocji (na przykład wzmianka w jakimś popularnym medium, wywiad w telewizji śniadaniowej), to wyniki mogą być mocno zniekształcone. Nawet wykorzystanie reklam Google Ads, gdzie mamy do czynienia z prawie tym samym medium (wyniki wyszukiwania w Google) i możemy zdefiniować konkretne słowa kluczowe, nie będzie idealnie odwzorowywać codziennych realiów pozyskiwanego ruchu.

Aby próba była reprezentacyjna, powinna mieć podobną strukturę do ruchu, który pozyskujesz na co dzień (lub który będziesz pozyskiwać). W praktyce to bardzo trudne, bo nie działamy w zamkniętym laboratorium. Najłatwiej będzie osiągnąć zamierzony efekt w przypadku serwisu odwiedzanego licznie przez użytkowników z różnych kanałów. Dla małych sklepów internetowych i startupów to kolejne ograniczenie.

Odpowiednio przygotowane warianty porównawcze

Częstym błędem w testach A/B w procesie optymalizacji serwisów internetowych i aplikacji jest niewłaściwa kreacja wariantu porównawczego. Prostszymi słowami – jeśli chcemy stworzyć jakąś nową, skuteczniejszą wersję, dajmy na to formularza rejestracji, to musimy przestrzegać określonych zasad. Jeśli kreacje będą różne na wielu poziomach (kolorystyki, liczby pól, treści komunikatów etc.), to może dojść do sytuacji, w której rzeczywiście dowiemy się, która opcja jest skuteczniejsza, ale nie będziemy wiedzieć, który ze zmienionych elementów na tym zaważył.

Może się okazać, że większa liczba pól wpłynęła na ostateczny rezultat (wzrost współczynnika konwersji) negatywnie, ale zmienione komunikaty lub treść przycisku zatwierdzającego rejestrację miały wpływ pozytywny. Zmieniając jednocześnie wiele elementów możemy nie dostrzec bardzo ważnych elementów wpływających na efektywność interfejsu i prowadzonej na stronie komunikacji. A przecież o to nam chodzi, aby stopniowo każdy element poprawiać. Dlatego też najbardziej wartościowe wnioski wyciągniemy przeprowadzając liczne i wielokrotne testy A/B mające na celu przeanalizowanie pojedynczych elementów (a dopiero na koniec możemy przeanalizować, jak zmiana całej kreacji w każdym z zakresów rzeczywiście wpłynie na konwersje).

Warto też zauważyć, że bardzo często skupiamy się na kwestiach związanych z kolorem buttonów, jakimiś pojedynczymi elementami w warstwie graficznej, w układzie elementów, gdy kluczowym czynnikiem wpływającym na konwersje mogą być same teksty (o czym wspominał Maciej Lewiński). Na potwierdzenie jeden z jego ostatnich tweetów:

Co tu dużo pisać. #copywriting od Teamu @paweltkaczyk miażdży moje dane w @googleanalytics #abtest 19 dni, 777 sesji i już jest zwycięzca pic.twitter.com/6Q9KAWDpNE

— Maciej Lewiński (@lewwwin) 5 maja 2017

Czy dobrze rozumiemy analizowane dane?

Umiejętność precyzyjnego zdefiniowania, z jakimi danymi mamy do czynienia jest kluczowa nie tylko przy testach A/B, ale także wtedy, gdy porównujemy dowolne wielkości – np. współczynniki konwersji w dwóch różnych okresach lub dla różnych źródeł ruchu.

Podstawowym narzędziem analitycznym, z jakim do czynienia mają marketerzy jest z pewnością Google Analytics. Często możemy spotkać się z pokusą wyciągania zbyt pochopnych wniosków na podstawie prezentowanych danych. Może nam się wydawać, że wszystko widać czarno na białym, ale należy pamiętać, czym de facto są prezentowane przez panel wartości.

Przykładowo – samo pojęcie Użytkownicy w panelu bywa zwykle mylnie interpretowane jako unikalni użytkownicy. Błąd ten popełniają marketerzy, wydawcy, blogerzy i sami klienci. W podstawowym ujęciu Użytkownicy w Google Analytics to liczba odrębnych ciasteczek zapisanych w przeglądarkach internetowych użytkowników w danym przedziale czasowym. Jeśli odwiedzisz stronę internetową z różnych przeglądarek, raz z komputera firmowego w pracy, raz z laptopa w domu, raz z tabletu i raz ze smartfona, Google Analytics tej strony zanotuje odwiedziny czterech użytkowników (mimo, że fizycznie będzie to jeden człowiek). Jeśli nawet ktoś odwiedza serwis regularnie z jednej przeglądarki, ale kasuje ciasteczka, to system będzie go zliczał wielokrotnie jako osobnych użytkowników.

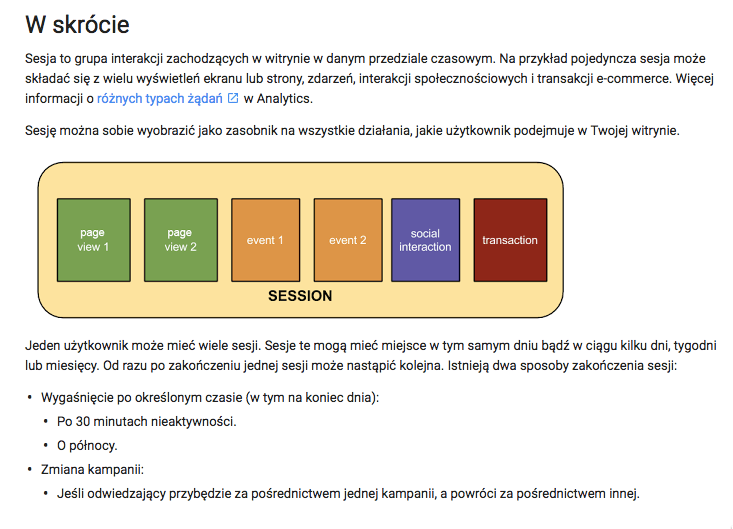

Warto też zwrócić uwagę, czym jest sesja. Użytkownicy Google Analytics, z którymi rozmawiam mają często problem ze zdefiniowaniem tego pojęcia:

Rozumiesz już zatem, że 5000 sesji na stronie absolutnie nie jest równe 5000 odsłon strony lub dotarciu do 5000 użytkowników? Ponadto należy mieć świadomość, w jaki sposób zbierane są informacje o współczynniku odrzuceń, czy średnim czasie na stronie. Bez tego jakakolwiek optymalizacja może być skazana na porażkę.

Czy praca na danych ma sens?

Oczywiście, że ma! Tzw. Analytics driven marketing to przyszłość działań marketingowych i sprzedażowych online (zwłaszcza w technicznym, optymalizacyjnym ujęciu, w kontekście pracy nad interfejsami, komunikatami, efektywnością procesów etc.). Jednak, aby podejmowane decyzje były zasadne i rzeczywiście przekładały się pozytywnie na biznes, musimy wiedzieć:

- jak poprawnie zbierać dane (np. wykluczyć ruch botów w próbie wykorzystanej do porównań),

- jak interpretować zbierane dane (np. co system rozumie przez Użytkownika lub Sesję),

- jak projektować eksperymenty (np. kreacja wariantów porównawczych) i jak interpretować ich wyniki,

- kiedy możemy skorzystać z poszczególnych narzędzi, np. popularnych testów A/B (a kiedy np. lepszą taktyką z perspektywy zwiększenia użyteczności i efektywności będzie analiza heurystyczna lub wywiady z małą grupą użytkowników).

Jeśli w swoim biznesie potrzebujesz wsparcia w procesach analitycznych i optymalizacyjnych, chcesz lepiej zrozumieć swoich użytkowników, poprawić efektywność swojego sklepu internetowego lub innego serwisu, w którym da się zmierzyć współczynnik konwersji, zapraszamy do kontaktu.

W punkt. Jako komentarz zalaczam zdjecie ktore zrobilem dzis rano w klasie polskiego gimnazjum. Co prawda, jako projektant uslug, chcialem dodac ze badania statystyczne powinny isc ramie w ramie z badaniami jakosciowymi 🙂

Pozdrawiam

https://uploads.disquscdn.com/images/3fba19eb8909349d4895461a7f0810767d92e551691ca18b70b767f208455c82.jpg

„poziomu istotności statystycznej (jakie ma być prawdopodobieństwo, że

nasze wnioski są prawdziwe – sugeruję przyjmować 99% chociaż w

niektórych badaniach społecznych i ekonomicznych przyjmuje się poziom

95%, aby ułatwić badania)” – i każdy statystyk- purysta zgrzyta zębami, bo poziom istotności definiuje się inaczej; a gdybyśmy chcieli być potoczni, to powiemy, że na 99% procent nasze wnioski nie są błędne, co nie jest równoznaczne 1:1, że są prawdziwe.

Wnikaliście na bazie jakich kalkulacji ta strona wylicza wielkość próby? Bardzo upraszczając za próbę dużą uważa się próbę > 30. Odnosząc to do konwersji przykładu jw. i duszyczek: 12 na tysiąc. Chcemy, by zaproponowana zmiana wpływa na konwersję 18 na tysiąc. Próba tysiąc nie wystarczy? Naprawdę potrzeba próby takiej wielkości? W ogóle nawet zakładając, że mamy taką próbę jak wyliczył calc to co dalej?

Pod linkiem są informacje dotyczące metodologii obliczania próby. Zakłada ona większą dokładność. Dalsze linki:

– https://www.optimizely.com/statistics/

– https://blog.optimizely.com/2015/01/20/statistics-for-the-internet-age-the-story-behind-optimizelys-new-stats-engine/

– https://www.optimizely.com/resources/stats-engine-whitepaper/

W tym ostatnim jest wyjaśniona różnica w metodologii względem klasycznego testu.