Ostatnio zostałem zapytany na konferencji FastTony.es w Gdyni o to, czy szybkość ładowania strony rzeczywiście jest czynnikiem rankingowym, czyli bezpośrednio wpływającym na pozycje. Problem wbrew pozorom nie jest wcale taki prosty, jak mogłoby się wydawać.

Spis treści

Szukasz usług SEO?

Czy szybkość ładowania strony wpływa na pozycjonowanie?

Z jednej strony Google nieustannie mówi, aby dbać o wydajność strony. Szybkość została ogłoszona jako czynnik rankingowy już w 2010 r. (https://developers.google.com/search/blog/2010/04/using-site-speed-in-web-search-ranking), lecz wiemy, że Google wiele rzeczy próbuje przeforsować dla własnych interesów (im efektywniej działa ich wielki ekosystem botów indeksujących zasoby sieci, tym lepiej i taniej). Wiele ich komunikatów ma więcej wspólnego z Public Relations niż z faktycznymi zmianami algorytmicznymi. Było tak na przykład w kontekście rzekomych bonusów wynikających z przejścia na szyfrowanie adresów. Pozytywny wpływ wprowadzenia HTTPS miał być znaczący, lecz z czasem sami googlersi (czyli pracownicy Google) przyznawali, że jest praktycznie znikomy (https://www.seroundtable.com/googles-https-ranking-boost-24002.html).

Wiele się mówi o tym, że szybkość ładowania strony ma mieć szczególne znaczenie dla użytkowników urządzeń mobilnych korzystających z Google. Do tego, jak przychodzi do konkretnych pytań, przedstawiciele wyszukiwarkowego giganta z Mountain View nie są jednogłośni (https://searchengineland.com/google-says-page-speed-ranking-factor-use-mobile-page-speed-mobile-sites-upcoming-months-250874) – mówi się o tym, że będzie to bardzo ważny element w mobile-first index, ale… no właśnie, nie wiadomo jeszcze kiedy i w jaki dokładnie sposób będzie to działać. Trochę więcej na ten temat przeczytacie tutaj: omówienie wypowiedzi Gary’ego Illyes’a na SMX.

Ponadto nie należy mylić wyniku w Google PageSpeed Insights z realną szybkością strony i tym, jak Google rzeczywiście podchodzi do tematu. Warto zwrócić uwagę, że prawdopodobnie w ogóle nie chodzi o szybkość strony wyrażoną liczbowo (np. we wspomnianym narzędziu PageSpeed Insights), a o cały szereg czynników powiązanych z szybkością – https://www.ezoic.com/pagespeed-insights-for-a-sites-seo-ux/. Faktyczne problemy mogą się pojawiać, dopiero gdy długi czas ładowania strony powoduje wzrost współczynnika odrzuceń – zwłaszcza w przypadku ruchu z wyszukiwarki (ludziom kończy się cierpliwość i wracają do wyników wyszukiwania).

Jednak czynniki behawioralne, takie jak wspomniany współczynnik odrzuceń, to temat na osobne rozważania. Ważne, aby pamiętać, że chodzi o unikanie złych wrażeń i nadwyrężania cierpliwości użytkowników. Lepsze i wyraźnie zauważalne rezultaty (w jakości ruchu, a być może także w wolumenie) da podniesienie wyniku PageSpeed z 55/100 do 75/100 niż np. z 80/100 do 100/100.

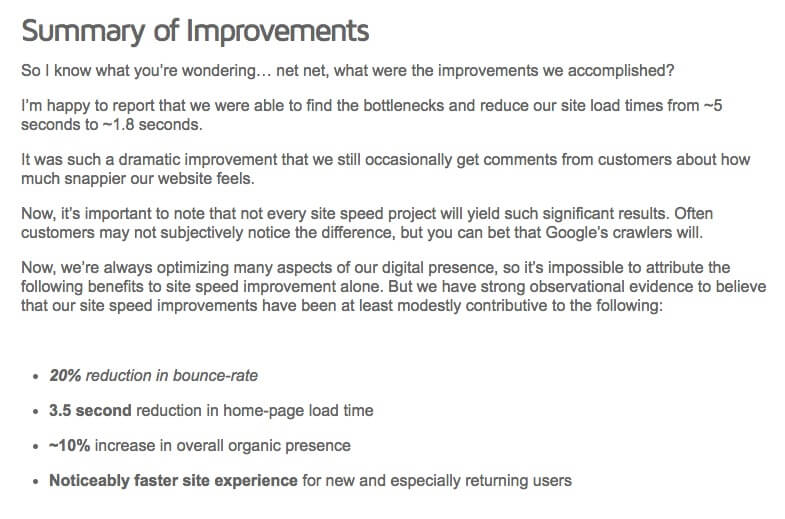

Case study opublikowane przez GTmetrix jakiś czas temu pokazuje wzrost widoczności strony w wynikach organicznych o ok. 10%. We wspomnianym artykule sugerowane jest, że przyczyną było przyspieszenie strony (chociaż jednocześnie dodano tzw. disclaimer: Now, we’re always optimizing many aspects of our digital presence, so it’s impossible to attribute the following benefits to site speed improvement alone).

źródło: gtmetrix.com

Swego czasu Jakub Wasielewski na blogu SEONinja opublikował artykuł Jak wprowadziłem stronę do top 1 dzięki Google Page Speed – Case Study. Przykład bardzo interesujący, ale ciężko go traktować jako uniwersalny dowód. To raczej ciekawa obserwacja, niż test jako taki.

To, do czego przywykliśmy już nie będzie takie samo.

Należy zwrócić uwagę na fakt, że jest coraz mniej uniwersalnych czynników, które działają zawsze i wszędzie w SEO. Na różnych rynkach, w różnych segmentach, branżach, a także w odniesieniu do poszczególnych typów zapytań (context is king), czynniki determinujące pozycje mogą być zupełnie inne.

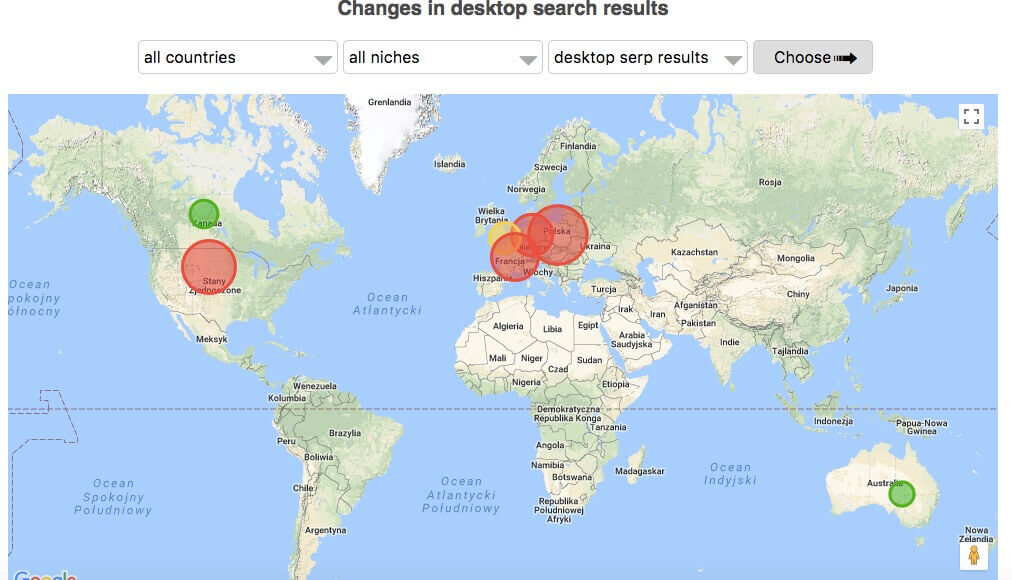

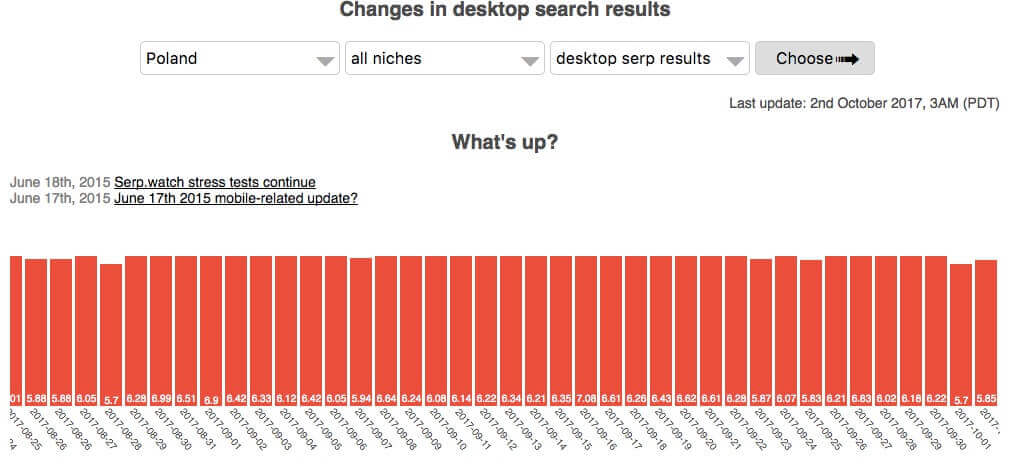

Można o tym przeczytać w artykułach w serwisach zagranicznych (nawet już z 2016 r.), jak i w Polskich – chociażby na blogu Senuto czy u Roberta Niechciała (Dlaczego Twoje linki nie działają? Cz. I). Praktyków chyba nie muszę przekonywać – obserwujemy coraz większą zmienność w Google przynajmniej od września 2016 r., kiedy w ogromnym stopniu zmieniło się to, jak Google traktuje linki, a także miejsce miało parę dziwnych, niepotwierdzonych aktualizacji. Wystarczy zajrzeć na serp.watch, aby zobaczyć, co się dzieje w wynikach:

źródło: serp.watch

oraz:

źródło: serp.watch

Według niektórych (i wiele argumentów przemawia za takim podejściem), różnego rodzaju update’y typu Fred w ogóle nie miały miejsca i jest to wciąż reminiscencja „real-time” Pingwina oraz innych poważnych zmian wprowadzonych już wcześniej (Pingwin, czyli algorytm związany z oceną profilu linków, szczególnie nastawiony na wykrywanie śmieciowych, spamerskich linków pozycjonujących). Polecam przeczytać tekst na ten temat na blogu NPROFIT (Aktualizacja Fred nie istnieje. Zmiany algorytmów są znacznie poważniejsze niż ci się wydaje).

Quo vadis SEO?

Gdy wprowadzamy dla naszych klientów poważne zmiany optymalizacyjne, realizujemy je kompleksowo i są rozłożone w czasie. Praktycznie zawsze znaczące przyspieszenie szybkości strony przekłada się pozytywnie na jakość ruchu. Często równolegle są realizowane działania z zakresu link buildingu. Trudno zatem wiążąco powiedzieć – tak, przyspieszenie strony spowodowało wzrosty o x%. Pamiętajmy jednak, że pojedyncze pozycje to jedno, a ogólna widoczność serwisu, dobra jakość ruchu (mało odrzuceń, odpowiednia głębokość wizyt, satysfakcjonujący współczynnik konwersji) to drugie. Skupiamy się na obu tych aspektach jednocześnie.

Mam wrażenie, że z każdym dniem coraz ciężej dowieść, że dane działania w pełni wpływają na SEO. Dopiero ich wypadkowa z czasem pokazuje efektywność (lecz bez możliwości sprawdzenia, czy 100% tych działań przełoży się na wyniki, czy tylko może część z nich). W SEO nie ma możliwości przeprowadzenia testów w pełni izolowanych, które byłyby zgodne z tzw. metodą naukową. W zasadzie problemów jest kilka:

- Po pierwsze, algorytm zmienia się kilkaset razy do roku (nie tak jak powtarza „opinia publiczna” tylko przy okazji jakichś głośniejszych update’ów co kilka tygodni / miesięcy).

- Nie mamy też wpływu na działania konkurencji, która równolegle może prowadzić działania pozycjonerskie różnego typu. Walka o obecność w Top10 to gra o sumie zerowej, więc każdy czynnik należy rozpatrywać w odniesieniu do pozostałych graczy.

- Nie wiemy również, czy przypadkiem równolegle do wdrażanych przez nas rozwiązań, Google nie przeliczyło wcześniejszych linków, czy zmian na stronie, nie przeindeksował zasobów i czy właśnie to nie wpłynęło na zmiany pozycji.

- Do tego dochodzą zachowania samych użytkowników. Sezonowość w przypadku wielu branż jest bardzo duża, więc nawet wzrost widoczności (pozycji / liczby fraz) nie zawsze w krótkiej perspektywie przekłada się na wzrost ruchu organicznego z Google.

Obserwacje trzeba by było prowadzić na kilku branżach, dziesiątkach lub setkach stron (o określonych parametrach, z określoną grupą kontrolną) z uwzględnieniem czynników behawioralnych, (strony popytowej), które mogą się zmieniać sezonowo i finalnie, tak naprawdę, porównania i analizy jakości ruchu w Google Analytics powinny być robione rok do roku. To trochę zbyt długa perspektywa, aby zwlekać z podejmowaniem decyzji i działań marketingowych. Mamy pod kontrolą mnóstwo zmiennych, ale tych, które są od nas niezależne jest wielokrotnie więcej.

Jak żyć, panie pozycjonerze?

Jedno jest pewne i to dużo łatwiej zaobserwować. Przyspieszenie strony poprawia jej użyteczność, dostępność, a zatem przekłada się na współczynnik konwersji (mniej odrzuceń, porzuconych koszyków). Dlatego jeśli zależy nam na ruchu konwertującym i zaangażowanym, to musimy dbać o szybkość strony.

Ponadto wychodzimy z założenia, że im większa niepewność w kontekście SEO, tym większy nacisk powinniśmy kłaść na takie kampanie, które mają szansę przełożyć się na inne KPI klientów – wzrost rozpoznawalności marki, wyższe współczynniki konwersji, poprawę jakości ruchu (nie tylko w kontekście współczynnika, ale także średniej wartości konwersji), zwiększenie wolumenu ruchu powracającego, zwiększenie liczby punktów styku z marką etc.

Dlatego też działania oparte na content marketingu i e-PR coraz częściej wydają się być zdrową alternatywą i czymś, co łatwiej zaakceptować marketing managerom, przedsiębiorcom, e-commerce managerom etc. Agencje SEO raczej długo nie zmienią się w agencje PR-owe czy UX, lecz w coraz większym stopniu jesteśmy „wpychani” do tych obszarów aktywności marketingowej. Czy to dobrze, czy źle? To już każdy – zarówno klient, jak i SEO-wiec – musi ocenić samodzielnie.

Podzielcie się swoimi przemyśleniami w komentarzach poniżej! 🙂